Die Maschinen sind los! 240 000 Wörter, 6 Monate: Im Magazin Nr. 8 zeigen wir einen aussergewöhnlich spannenden Beitrag zum Thema maschinelle Übersetzung. Über ein halbes Jahr hinweg haben wir drei Maschinen mit einem statistisch relevanten Volumen an authentischen Texten getestet. Lesen Sie hier unsere Findings noch einmal als Blog.

Beim Thema maschinelle Übersetzung (MT) geraten wir zurzeit in echte Hoch- und Weitererzählstimmung. Denn mit den Basler Versicherungen durften wir im letzten halben Jahr ein sagenhaftes Pilotprojekt durchführen, um herauszufinden, welche Maschine sich am besten für diesen langjährigen Lieblingskunden eignet. Und obwohl wir als Übersetzer sonst ja eher still im Hintergrund tüfteln, müssen wir die spannenden Ergebnisse nun einfach mal herausposaunen.

Riesenvolumen und ganz viel Zeit: Ein bahnbrechendes MT-Projekt

Klar, es gibt schon einige Statistiken dazu, wie viel Zeit bzw. Ressourcen man ungefähr mit MT sparen kann. Aber viele Faktoren können in kleinen oder allgemeinen Versuchsprojekten gar nicht geklärt werden, weil die Resultate so stark von Sprachkombi, Textsorte, (gutem/schlechtem/fehlendem) Post-Editing usw. abhängen. Im Pilotprojekt mit der Basler hingegen haben wir über einen langen Zeitraum hinweg ein sehr grosses Volumen verarbeitet und die Ergebnisse akribisch nach Fachgebieten, Textsorten und Sprachen analysiert. Da gab es dann sehr genaue Ergebnisse …!

Mit folgenden Fragen kam die Basler auf Diction zu:

Welches System bringt uns die grösste Effizienz? Und welche Basler-Texte und -Sprachen eignen sich gut oder weniger gut für MT? Wie und was wurde genau getestet?

Folgende (hier nicht näher benannte) Systeme kamen zum Einsatz, wobei es Anfang Februar 2021 mit Maschine 1 losging und Ende Juli der letzte Text durch Maschine 3 ratterte:

Maschine 1

Diese Maschine ist nicht mit Terminologie oder anderen Daten-Korpora trainierbar. Es handelt sich um die kostenpflichtige Profivariante eines auch frei im Netz verfügbaren Systems. Die Datensicherheit ist gut.

Kosten: niedrig

Trainingsmöglichkeiten: keine für die

betreffenden Sprachen

Sicherheit: gut

Maschine 2

Dies ist ein auf den Diction-Servern betriebenes System, das sehr gute Sicherheit bietet. Zum Training nutzten wir von Basler zur Verfügung gestellte Daten (Fachbegriffe aus Unternehmenstexten), Translation-Memorys (TMs) sowie frei

verfügbare von uns bereinigte Textkörper.

Kosten: mittel

Trainingsmöglichkeiten: gut

Sicherheit: sehr gut

Maschine 3

Das Training erfolgte mit Basisdaten des Anbieters, Daten von Basler sowie mit TM- und Termbank-Daten, wobei die Benennungen nicht nur an der richtigen Stelle eingesetzt, sondern auch grammatikalisch an das Satzgefüge angepasst werden. Die Maschine kann sogar lernen, die richtigen Apostrophe zu setzen oder Zahlenformate in der gewünschten Form anzuwenden. Auch die Sicherheit ist sehr gut, denn dem Kunden steht ein eigener Server beim Anbieter zur Verfügung.

Kosten: hoch

Trainingsmöglichkeiten: sehr gut

Sicherheit: sehr gut

Der Einsatz der Maschinen erfolgte im Live-Tagesbetrieb. Die maschinellen Übersetzungen wurden durch Post-Editoren geprüft und korrigiert. Der Anspruch waren zu 100 % einwandfreie Texte, die sich nicht von einer Humanübersetzung unterscheiden. Auf diese Weise wurden 417 Übersetzungen mit insgesamt 245 000 Wörtern unter die Lupe genommen. Eine Riesenmenge!

Bewertung der Ergebnisse

Wie beurteilt man, ob das Resultat gut ist? Es gibt zwar automatische Bewertungsverfahren, mit denen man eine Maschinenübersetzung recht schnell bewerten könnte. Allerdings sind die Ergebnisse, die auf einer beschränkten Anzahl von Beispielsätzen beruhen, nur bedingt aussagekräftig. Sobald zum Beispiel statt einer antrainierten Benennung ein Synonym verwendet wird, gibt es gleich Punktabzug, selbst wenn das Synonym genauso korrekt ist. Die Prüfung durch ein geschultes menschliches Auge hat sich daher als weit effektiver herausgestellt. Oder zumindest ist eine solide Kombiprüfung von Mensch und Maschine durchaus ratsam.

Bei Maschine 3 ist die automatische Bewertung bereits im System enthalten. Übrigens: Das reine «Drüberschauen» beim Auftraggeber des Kunden («Ja, liest sich doch gut») gilt ebenfalls nicht wirklich als Prüfung. Denn eine maschinelle

Übersetzung kann sich zwar wunderbar flüssig lesen, aber dennoch inhaltlich falsch sein – was ein sprachlicher Laie womöglich gar nicht bemerkt. Um eine Maschine zu bewerten, müssen daher Profis die Übereinstimmung von Ausgangs- und Zieltext prüfen.

Jetzt wirds spannend: Welche Fehler haben die Maschinen gemacht?

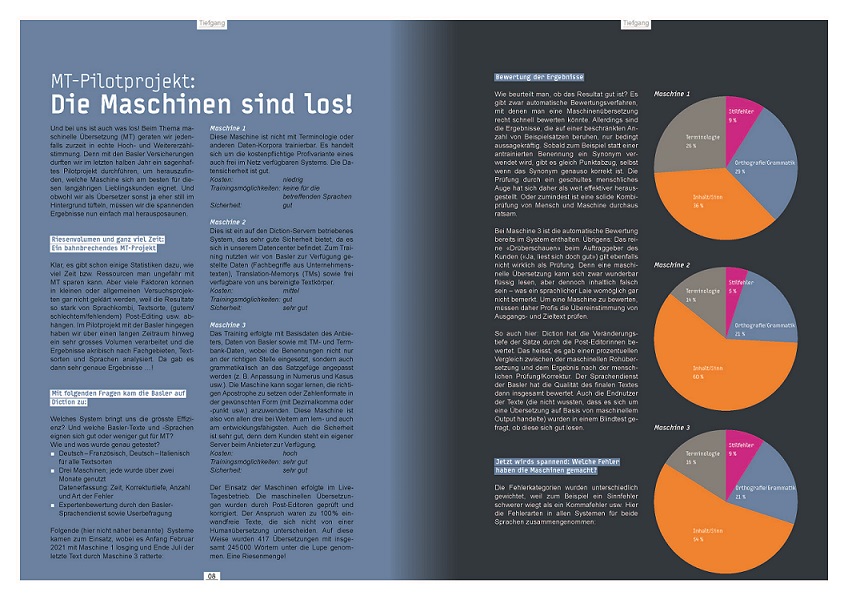

Die Fehlerkategorien wurden unterschiedlich gewichtet, weil zum Beispiel ein Sinnfehler schwerer wiegt als ein Kommafehler usw. Hier die Fehlerarten in allen Systemen für beide Sprachen zusammengenommen:

Inhaltlich verrannten sich alle drei Systeme am häufigsten. Dies sind leider auch die folgenschwersten Aussetzer, da der Textsinn ja die Basis für das Verständnis darstellt. Orthografie und Grammatik folgten mehr oder weniger deutlich auf dem zweiten Platz. Ein grosser Unterschied zwischen den beiden geprüften Sprachen war, dass bei Italienisch die Terminologie (grau) ein grösseres Problem darstellte als bei Französisch. Dies vor allem bei Maschine 1, die nicht trainierbar ist. Doch auch die beiden trainierbaren Systeme zeigten den Trend zu weit mehr Terminologiefehlern in Italienisch. Vermutlich, weil für Französisch mehr sprachliche Quellen fürs Training verfügbar sind.

Hier beispielsweise die Fehlerart-Verteilung im Fachgebiet Bankwesen mit Maschine 3 in beiden Sprachen. Dabei sehen wir in Französisch fast ausschliesslich Sinnfehler, in Italienisch sind die Fehlerarten gleichmässiger vertreten.

Kleiner Exkurs: Wie läuft eine maschinelle Übersetzung mit Post-Editing eigentlich ab?

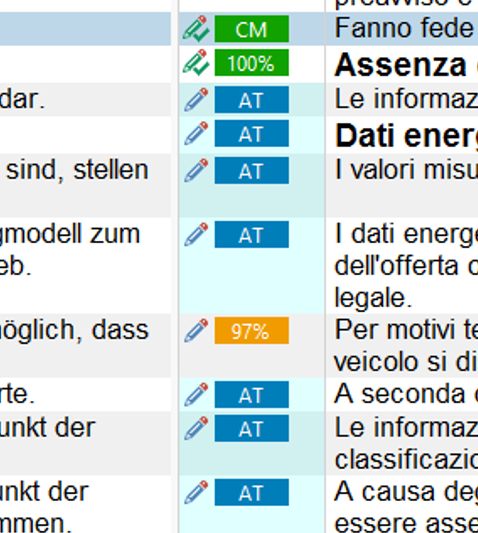

Sämtliche Texte werden zuerst durch TM-Einträge vorübersetzt. Das heisst, alle Segmente, für die das TM bereits eine Übersetzung gespeichert hat, brauchen nicht mehr durch die Maschine geschickt zu werden.

Die Post-Editorin erkennt beim Prüfen der Texte in der Übersetzungsumgebung Trados Studio, ob ein Segment aus dem TM stammt oder von der Maschine («NMT» im Bild rechts kommt aus der MT-Maschine, alles andere aus dem TM). Den Treffern aus dem TM kann man vertrauen, da sie ja (irgendwann einmal) von einem menschlichen Übersetzer erstellt wurden. Sätze aus der Maschine müssen hingegen eingehender geprüft werden, denn sie können von guter oder aber schlechter Qualität sein.

Und wie viel Zeit spart maschinelle Übersetzung

Ein menschlicher Übersetzer übersetzt je nach Thema ca. 200 bis 250 Wörter pro Stunde. Ist MT mit Post-Editing bei gleicher Qualität schneller, dann lohnt sich also der Einsatz der Maschine. Bei Italienisch war die Zeiteinsparung über alle Systeme hinweg geringer als bei Französisch. Bei Maschine 3 lagen die Zeitwerte noch am nächsten beieinander.

Allerdings kam es hierbei auch stark auf die Textsorte und das Fachgebiet an. So war bei medizinischen Texten der Post-Editing-Prozess für den Output aus Maschine 1 zeitintensiver als etwa bei Texten aus dem Bereich Medien und Werbung. Gerade auch Texte mit Schweizer Rechtsterminologie sind für alle nicht trainierbaren Maschinen eine Herausforderung, weil fast nur Begriffe aus Frankreich, Italien und Deutschland im System hinterlegt sind. Daher hat Maschine 1 bei solchen Texten besonders deutliche Probleme.

Wichtig ist: Nicht nur die eingesparte Zeit bei vergleichbarer Qualität, sondern auch die Anschaffungs- und Betriebskosten sind von Bedeutung. Die drei Systeme gelangen je nach Jahreswortmengen schneller oder weniger schnell an den Break-even-Point. Die Basler hat ein so grosses Übersetzungsvolumen, dass sich auch mit der teuersten Maschine 3 die Investition ziemlich schnell lohnt. Bei Kunden mit geringerem Jahresvolumen kann es anders aussehen. Besonders, wenn man selbst nur kleine eigene Korpora (also Unternehmensterminologie, TMs usw.) mitbringt und daher zusätzliche Daten eingekauft oder diese gefunden werden müssen. Bei selteneren Sprachkombinationen kann das schwierig werden. Es gibt also keine Zauberformel, die für jeden gilt.

Das grosse Fazit

Das allerletzte MT-Geheimnis haben wir vielleicht nicht gelüftet, aber das Pilotprojekt hat definitiv einen Wow-Effekt aufgrund seines Umfangs und seiner Akribie. Unser Kunde kennt jetzt ganz genau die Vor- und Nachteile der einzelnen Systeme in den beiden Sprachen sowie für verschiedene Fachbereiche und Textsorten. Auf dieser Grundlage kann er sich nun für das System entscheiden, das insgesamt am besten passt.

Und unsere Profis für maschinelle Übersetzung sind auch glücklich, denn sie konnten drei Systeme über Monate hinweg mit einer riesigen Datenmenge analysieren. Damit sind wir umso besser für die nächsten Projekte gerüstet.

Falls Sie sich also mit unseren MT-Experten zu diesem Thema unterhalten möchten, rufen Sie uns an. Wir freuen uns schon!

Das könnte Sie auch interessieren

Praktikum bei Diction: Ein Blick hinter die Kulissen

Interessierst du dich für ein Praktikum bei Diction? Dann erfährst du hier, was dich dabei alles erwartet. Die Suche nach einer Praktikumsstelle kann manchmal eine Odyssee sein. Ich erinnere mich, wie viele Schreiben ich aufgesetzt habe, als ich auf der Suche nach dem «Heiligen Gral» war. 😉 Nun sind die Rollen vertauscht, und ich darf…

Expats aufgepasst: In der Muttersprache fit bleiben, so gehts!

In der Muttersprache fit bleiben, wenn man in in der grossen weiten Welt lebt, ist gar nicht so einfach. Expats wissen, wovon ich spreche. «Expats» heisst auf Französisch «expatriés». Und in Frankreich, wo ich aufgewachsen bin, verbinden viele Leute diesen Begriff mit Menschen, die für Grosskonzerne ins Ausland gehen, in schicken Vierteln wohnen und ihre…

Auf die Plätze, fertig, Messe! – Der Antistress-Service für Uhrenkunden zu Messezeiten

Momentan läuft die renommierte Uhrenmesse Watches and Wonders (ehemals der SIHH – Salon International de la Haute Horlogerie) in Genf. Es ist einer der weltweit wichtigsten Haute-Horlogerie-Events, an dem mehr als 38 Uhrenmarken ihre Neuheiten und Trends in ziemlich spektakulärer Atmosphäre präsentieren. Klar ist: Die Vorbereitungen auf diesen Event sind unglaublich aufwendig. Das betrifft nicht…